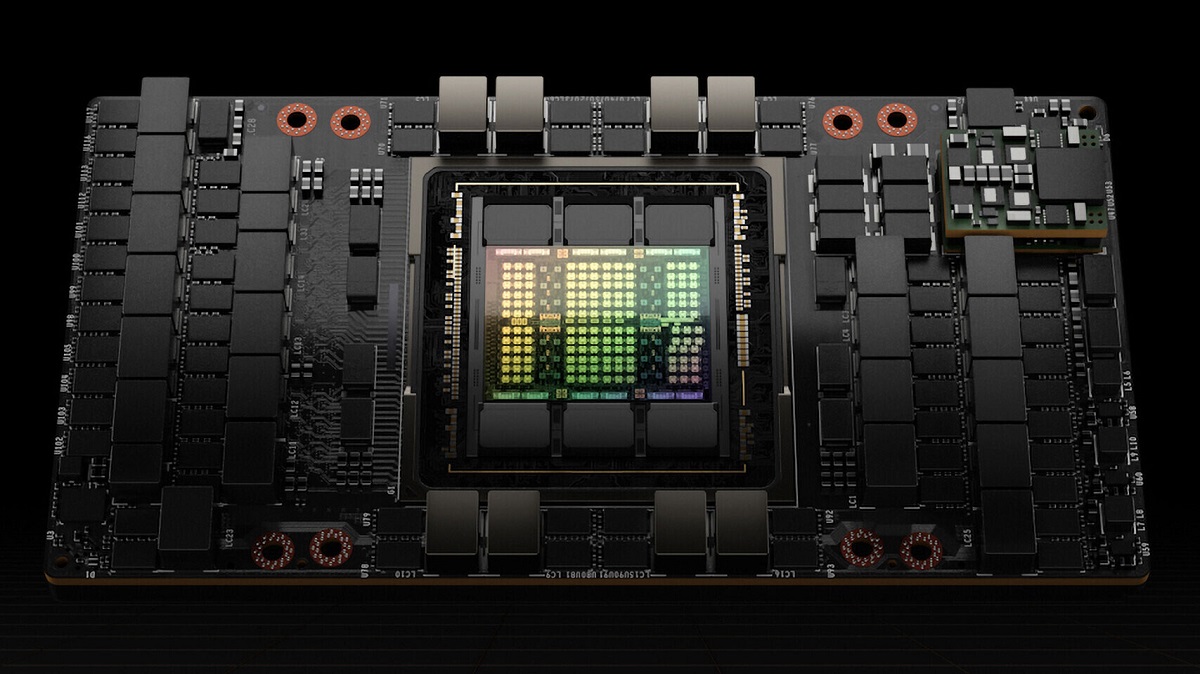

在GTC 2022上,英伟达发布了新一代基于Hopper架构的H100,用于下一代加速计算平台。正如英伟达所言,这是专门为超级计算机设计的GPU,专注于AI性能,通过架构更新和工艺提升,使其性能和效率提高到新的水平。

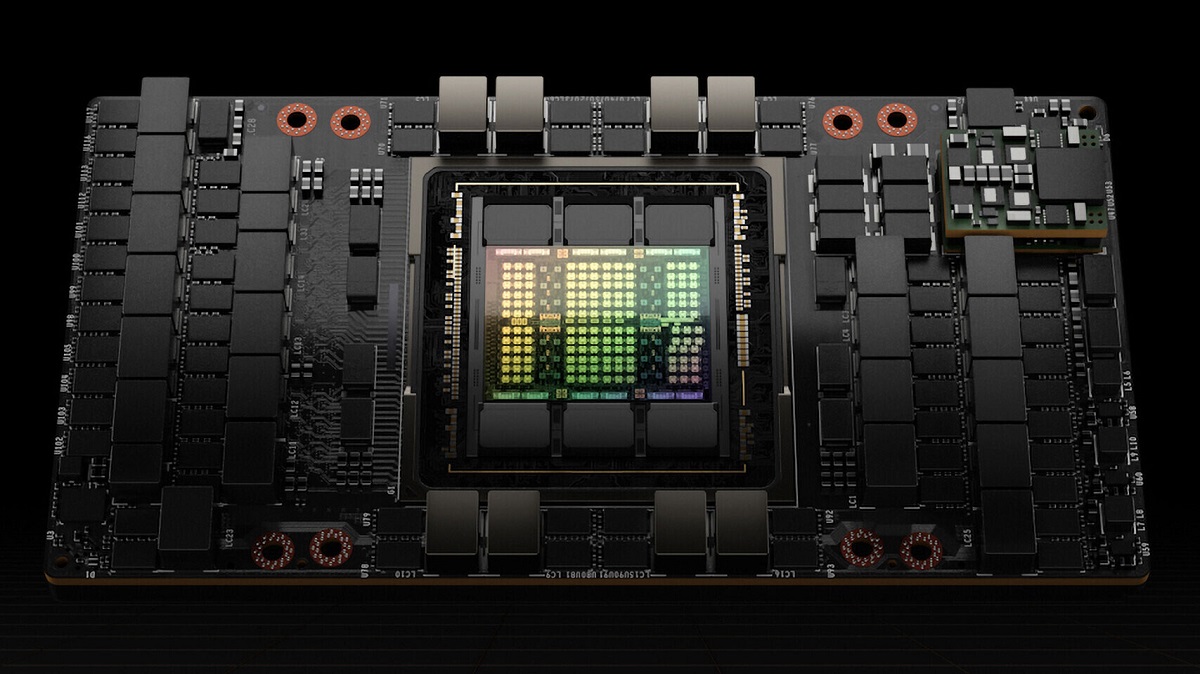

NVIDIA H100拥有800亿个晶体管,相比上一代的A100,有着六倍的性能提升以及两倍的MMA改进。该款GPU为CoWoS 2.5D晶圆级封装,单芯片设计,采用了台积电(TSMC)的4nm工艺制造,不过是为英伟达量身定制的版本,与一般的N4工艺有所差别。

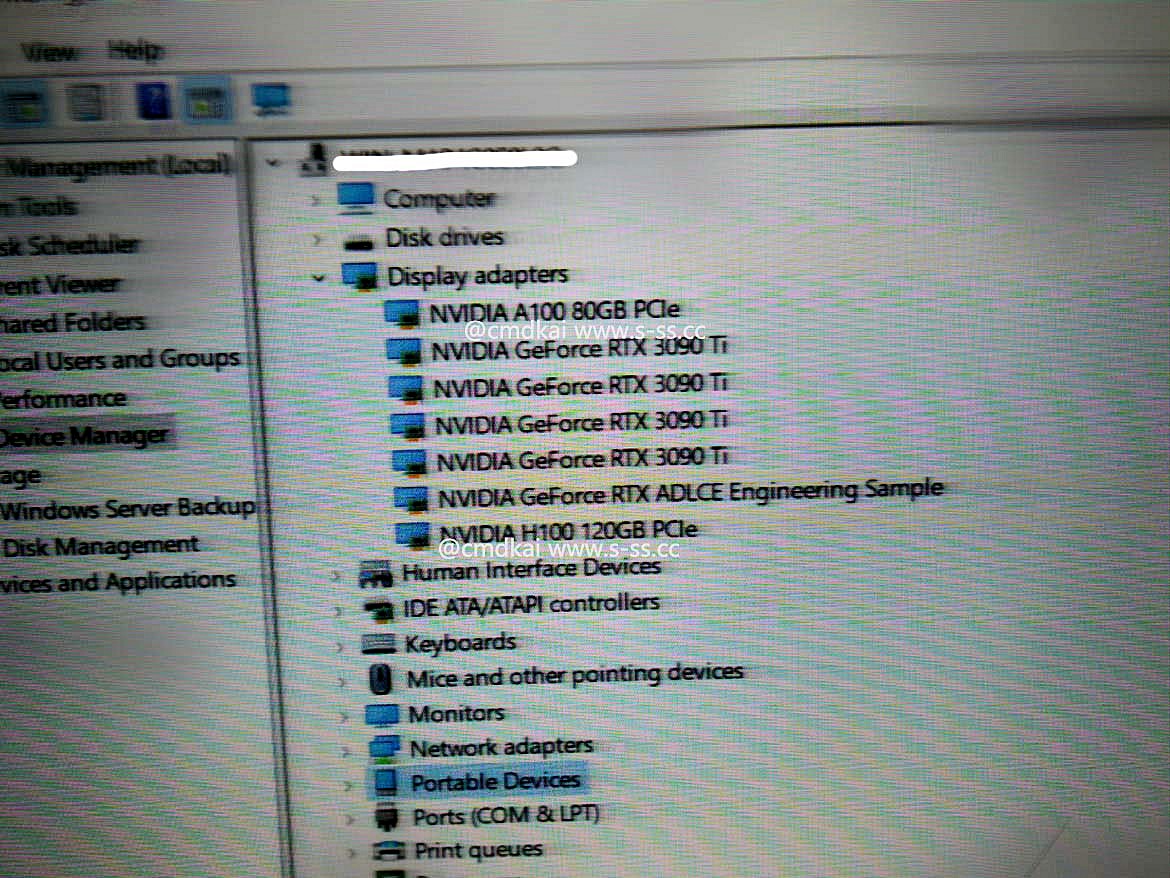

英伟达没有公布H100的核心数量和频率。据了解,完整的GH100芯片配置了8组GPC、72组TPC、144组SM、共18432个FP32 CUDA核心。其采用了第四代Tensor Core,共576个,并配有60MB的L2缓存。不过实际产品中没有全部打开,其中SXM5版本中启用了132组SM,共16896个FP32 CUDA核心,528个Tensor Core以及50MB的L2缓存,而PCIe 5.0版本则启用了114组SM,FP32 CUDA核心数量只有14592个。此外,前者的TDP达到了700W,后者则为350W。

英伟达表示H100的FP64/FP32运算性能为60 TFlops,FP16运算性能为2000 TFlops,TF32运算性能为1000 TFlops,均是A100的三倍。此外英伟达在Hopper架构上改进了对FP8运算的支持,使其运算性能达到了4000 TFlops,是A100六倍。由于缺乏原生FP8,不得不依赖于FP16,英伟达通过新的转换器引擎,将根据工作负载在FP8和FP16之间自动切换。

据英伟达介绍,H100支持英伟达第四代NVLink接口,可提供高达900 GB/s的带宽。同时H100还支持不使用NVLink接口的系统,以PCIe 5.0代替,带宽为128 GB/s。英伟达表示,H100是第一款支持PCIe 5.0标准的GPU,也是第一款采用HBM3的GPU,最多支持六颗HBM3,带宽为3TB/s,是A100采用HBM2E的1.5倍,默认显存容量为80GB。

英伟达还添加了旨在加速动态编程的新DPX指令,以帮助更广泛的算法,包括路线优化和基因组学。英伟达表示这些算法的性能比其上一代GPU快了七倍,比基于CPU的算法快了四十倍。Hopper架构还对安全性做了改进,多实例GPU(MIG)现在允许在单个H100 GPU上运行七个安全租户。

与A100一样,英伟达会将新款的H100添加到DGX H100机架式服务器。每个DGX H100系统包含8块H100,共640GB的HBM3显存,可提供32 PFlops的AI计算性能,以及480 TFlops的FP64运算性能。系统中的每个GPU都通过第四代NVLink连接,带宽是上一代的1.5倍,加上全新的VNLink Swtich互连系统,可连接32个DGX H100节点,以构建下一代NVIDIA DGX SuperPOD超级计算机。

由于H100分别有SXM和PCIe两种外形,以支持不同的服务器设计要求。为了更好地适应不同的系统,英伟达还提供了H100 CNX融合加速器,将H100与NVIDIA ConnectX-7 400Gb/s InfiniBand和以太网SmartNIC配对,为I/O密集型应用提供突破性的性能。Hopper架构GPU还可以与具有NVLink-C2C互连的Grace CPU搭配使用,成为Grace Hopper超级芯片,为大规模HPC和AI应用提供服务。

NVIDIA H100可广泛部署在各种类型的数据中心里,将向全球范围内的云服务供应商和计算机制造商提供,预计今年第三季度开始供货。